L’intelligence artificielle (IA), un sujet d’actualité en plein essor

Ce nouveau domaine technologique permet de traiter les données comme il n’a jamais été possible auparavant. L’analyse de l’information demeure une révolution pour qui sait en tirer parti et les opportunités sont nombreuses : développer son business, comprendre les processus en profondeur, identifier les comportements, ou encore mieux prédire le futur.

En réalité, l’IA, loin d’être un concept récent, englobe diverses notions. La production automatique d’un résultat est une forme d’intelligence que l’on dit artificielle car provenant d’une machine. De nombreux algorithmes sont en fait supervisés, car ils fonctionnent uniquement sur la base de données existantes préparées consciencieusement (ou pas [1]) par des humains. Cependant, une autre catégorie d’algorithmes est capable d’apprendre en autonomie à condition d’auto-évaluer la pertinence des résultats.

Par exemple, il est relativement aisé pour une IA de savoir si une partie de plateau est gagnée en appliquant les règles du jeu que de savoir si un alignement de plusieurs mots est une phrase sensée répondant à une question, ou si l’image d’un chat est bien un chat et non un chien déguisé [2]. Ce défi mathématique est assez abstrait mais il trouve des applications très concrètes, notamment pour les entreprises où la soif de données et le besoin de créativité pour innover sont omniprésents.

Artificial Narrow Intelligence

ANI

Artificial General Intelligence

AGI

Artificial Super-Intelligence

ASI

Pour appréhender ce domaine et comprendre objectivement quel est le positionnement de l’offre de l’éditeur SAP, nous nous intéresserons dans cet article à ce qu’est l’intelligence artificielle. Un second article se penchera plus spécifiquement sur les outils mis à disposition par SAP pour accompagner cette transformation numérique.

Alexandre Bréard est ingénieur et expert SAP au sein du pôle logistique de DUONEXT.

Il suit avec intérêt les nombreuses évolutions des technologies informatiques depuis 2000.

01 – Principes de fonctionnement de l’IA

L’acronyme « IA » est quelque peu modifié désormais, car artificiel ne veut pas dire superficiel. Cette intelligence et cette information se veulent aussi augmentées ou améliorées. En pratique, il s’agit toujours d’un problème mathématique dont la finalité est de combiner des milliers de paramètres pour en déduire un résultat, le tout en minimisant le taux d’erreur et parfois sans connaître précisément les étapes du calcul. La difficulté principale est donc de trouver la formule « juste » en faisant varier ses paramètres [3], de la faire évoluer tout au long de son cycle de vie, et d’en tirer les conclusions adéquates pour développer la connaissance de données. Chaque modèle d’IA est conçu pour répondre à un problème spécifique. Lors de la phase d’entraînement, les paramètres sont affinés et ajustés pour converger vers les bonnes réponses, le plus exactement possible.

Parfois, il est nécessaire de spécialiser l’entraînement avec des données ciblées pour gagner en précision sur des sujets particuliers. À la fin de cette phase, extrêmement exigeante et coûteuse en termes de ressources (préparation des données, charge de calculs, ajustement des formules, validation des résultats, estimation de la précision…), le modèle peut être exploité dans votre paysage applicatif sans trop solliciter de ressources supplémentaires. Il n’existe pas de modèle vraiment universel ayant réponse à tout, mais une multitude de modèles différents adaptés à des tâches définies et qu’il est potentiellement possible de combiner. Multiplier les modèles implique une accumulation de charges de travail qui finissent par s’avérer coûteuses.

On parlera « des IA » comme étant « différents algorithmes » qui n’ont pas tous le même niveau de sophistication, ni la même conception, ni les mêmes auteurs. Dans l’ensemble, le principe théorique mathématique reste le même :

- Les IA dites faibles ne savent faire que ce pour quoi elles ont été conçues: analyser une image, classifier un document, produire une recommandation d’achat… Chaque nouveau besoin doit s’accompagner d’un modèle nouveau ou réadapté

- Les IA dites fortes ou à but général (general-purpose IA) [4] sont capables de faire autre chose que ce pour quoi elles ont été conçues et sans qu’il ne soit nécessaire de retravailler beaucoup le modèle

- Le stade ultime est la prise de conscience et donc le surpassement des Machines sur les Humains. Dans l’imaginaire collectif, des œuvres cinématographiques comme Ex_Machina, Terminator, Surrogates ou I, Robot mettent en scène le développement avancé de machines robots dotées de pensées et d’émotions, et du monde potentiellement menaçant qui pourrait en résulter.

Fondamentalement, au-delà du résultat ludique des algorithmes, l’enjeu crucial réside dans la maîtrise de la qualité des résultats pour que ces derniers soient précis, pertinents et véridiques (pas seulement persuasifs [5]), sans biais moraux et idéalement applicables aux contextes professionnels.

L’automatisation sans contrôle peut exposer les entreprises à des déconvenues de relation avec les clients ou le public [6] [7] par exemple. Il convient donc de choisir les sujets à traiter, d’évaluer les produits, de tester abondamment, d’explorer les usages… Une véritable chaîne de valeur et d’organisation se construit autour de ces technologies, soulignant ainsi l’importance d’être bien accompagné, organisé et engagé.

Téléchargez notre dernier Livre Blanc :

L’intelligence artificielle et SAP

02 – Différents modèles utilisés en IA

Modèle de régression

Un tout premier type d’algorithme est la régression. Son objectif principal est d’identifier une formule de calcul dont la courbe, si elle était tracée, se rapprocherait le plus près possible de l’ensemble des points de mesure observés. C’est ainsi que tous les collégiens ont appris à relier la tension et le courant grâce à la loi d’Ohm, et les lycéens ont exploré le phénomène de diffraction à travers l’étude de la tâche d’Airy.

En entreprise, on peut appliquer cette technique pour surveiller les paramètres d’une machine et anticiper ses pannes lorsque la combinaison de certains paramètres diverge par rapport au modèle attendu. La technique permet de quantifier les corrélations entre les mesures et d’identifier les paramètres sans influence. Une maintenance sous contrôle donnera de meilleurs temps de production, et la qualité des produits améliorera la satisfaction des clients.

Ce sujet, éminemment mathématique et abstrait, repose sur une multitude de formules statistiques pour garantir sa fiabilité. Les machines et logiciels apportent une facilité dans l’acquisition des données, l’optimisation des formules et l’exécution des calculs. Par ailleurs, la mise en réseau des appareils joue un rôle crucial dans l’accroissement du volume des données et des besoins en termes d’exploitation [8].

Modèle de classification (PredIA)

Un second type d’algorithme est la classification. L’idée est de mettre en relation des paramètres non numériques (mots, couleurs, attributs, numéro ordinal…) pour déduire des caractéristiques communes et prédire de nouveaux cas. Dans l’espace multi-dimensionnel des combinaisons possibles de paramètres, les éléments similaires auront une tendance naturelle à se regrouper, et les incertitudes proviendront des éléments proches des délimitations trouvées par l’algorithme. Par exemple, si l’un des paramètres d’entrée est la couleur jaune, il est peu probable que le résultat soit un éléphant, mais plutôt un oiseau qui peut être petit ou gros. Le résultat de la classification a un caractère probabiliste. Il faut alors paramétrer le modèle pour limiter les erreurs et réduire les accidents qui peuvent en découler.

La multi-dimensionnalité empêche souvent de se faire une représentation visuelle pour contrôler les données [9]. Ce sont alors généralement les résultats opérationnels et les statistiques qui trahissent les erreurs de conception du modèle. Cette catégorisation automatique va accélérer le traitement d’un ticket de support informatique, identifier la nature d’un message (achat, résiliation), évaluer la sensibilité d’un document, donner le nom d’un animal représenté sur une image … Les algorithmes de classification qualifient les données existantes sans en générer de nouvelles. Ils jouent ainsi un rôle fort d’assistance, et peuvent avoir une spécialisation et un potentiel très élevés. L’enjeu majeur réside dans la capacité à classifier, avec précision, une tâche qui s’avère souvent coûteuse à réaliser. En effet, vous devez disposer d’un jeu de test conséquent, spécialisé et représentatif pour superviser l’entraînement, à moins d’utiliser des jeux de données publics ou des techniques de deep learning pour suppléer votre démarche [10].

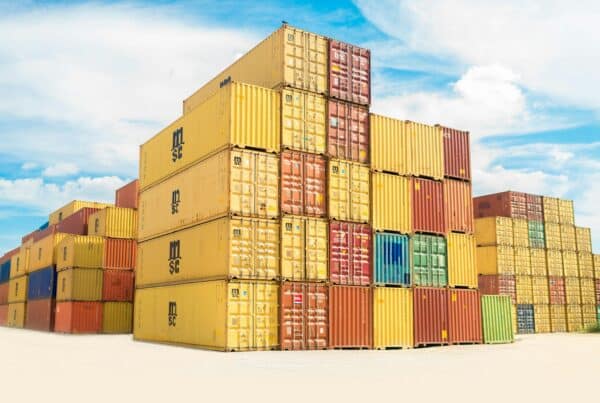

En travaillant sur des données transactionnelles qui témoignent de la réalité d’un historique, les données d’entraînement peuvent se générer sans supervision directe tout en restant très précises et adaptées à votre business. Par exemple, le processus récurrent que sont les expéditions peut être évalué selon différents critères (criticité d’un produit, transporteur, destination, effectifs présents, moment dans l’année…).

On peut alors évaluer les livraisons en cours qui ont un risque d’être livrées en retard [11], ou encore trouver les critères sans influence sur lesquels il sera inutile d’agir pour augmenter le taux de service. Similairement, l’évaluation des fournisseurs est multicritère : on peut pondérer des paramètres numériques ou jouer sur la similitude d’attributs entre fournisseurs.

L’utilisation d’un modèle entraîné (nommé l’inférence) est souvent une formalité technique : l’exécution est rapide mais peut nécessiter beaucoup de mémoire. Pour renforcer le modèle sur la durée, les erreurs corrigées et les éléments nouveaux peuvent être réinjectés dans le modèle, et les très anciennes données d’entraînement supprimées. Pour éviter les boucles de rétroaction, un modèle ne doit jamais apprendre de ses propres résultats au risque de s’empoisonner. Progressivement et grâce à votre investissement de temps et de moyens, le modèle va gagner en précision (85% est un objectif raisonnable) et répondre de mieux en mieux à vos besoins.

Comme il ne faut parfois que quelques milliers d’exemples, ce type de modèle peut être facilement paramétré et déployé dans vos applications.

Deep learning et modèle génératif (GenIA)

Un troisième type d’algorithme clé dans le domaine de l’IA est celui des réseaux de neurones utilisés en apprentissage profond (deep learning). L’idée est de combiner plusieurs couches de paramètres entrants et sortants reliés par des coefficients et des formules de simplification pour former un réseau évoquant la structure du cerveau mais sans jamais l’équivaloir.

En traversant le modèle, les données vont subir une transformation qui va au-delà d’une simple classification ou d’un calcul. Par exemple, une liste de mots peut donner un nouveau mot, ce qui permet de compléter des phrases en répétant l’opération plusieurs fois. C’est ainsi par combinaison statistique de mots avec d’autres mots que sont nés les algorithmes de traduction automatique. Les réseaux de neurones permettent de gagner en flexibilité par rapport aux logiques procédurales. L’algorithme va deviner par essais successifs en apprenant de ses erreurs, et il est parfois impossible de faire autrement [12] [13].

Cette flexibilité permise par l’essor des sciences et surtout de la puissance des puces électroniques permet d’entrer dans l’univers de l’IA générative. L’idée est de convertir des données aléatoires en une information intelligible fortement ressemblante à des données réelles. C’est pourquoi il est possible de produire tout type de contenus avec un niveau troublant de détails [14]

Pour le texte, on parle de grand modèle de langage (LLM, large-language model [15]). L’idée est de trouver le prochain mot probable par rapport à ceux déjà énoncés et connus d’un référentiel entraîné. La véritable complexité réside dans la capacité à conférer un sens réel aux mots, au-delà de la simple production d’un assemblage aléatoire de termes [16]. Prenons l’exemple du modèle de Meta nommé LLaMA [17] : il est décliné en une version “charabia” issue de la compilation statistique des textes d’entraînement, et en une version chat un peu plus spécialisée qui peut dialoguer avec une personne. Le traitement naturel du langage (NLP) est l’un des domaines les plus complexes qui soient en raison des alphabets, des règles orthographiques, du vocabulaire, de la nuance des mots, des double-sens, des non-dits, de la culture, etc… mais c’est aussi la fonction la plus prometteuse. Le texte est la base de tout pour parler, traduire, vocaliser, inventer, penser… L’élaboration de fonctions autour des textes est résolument sans limite [18] et c’est ce qui a passionné la presse lorsque les entreprises du numérique ont démontré leurs premiers exploits.

Pour l’audio, il s’agit du même principe de prédiction que le texte, à la différence que la source de données est dans un format différent. Les champs d’application sont très spécialisés lorsqu’il s’agit de composition musicale. Lorsque l’audio est couplé au texte, il est possible de vocaliser n’importe quel texte avec n’importe quelle voix à destination des utilisateurs mal-voyants par exemple. Les risques de cette technologie couplée à l‘image sont les usurpations d’identités pour faire dire n’importe quoi à n’importe qui (même aux disparus [19]), ce qui altère en premier lieu la confiance envers les médias [20] et les réseaux sociaux.

Pour l’image, les progrès récents sont rendus possibles par les banques d’images associées à leurs textes [21]. Le principe des modèles dits de diffusion est de faire converger l’image et le texte à partir d’un nuage de points aléatoires conférant un caractère absolument unique à l’image résultante. Les ressources matérielles et financières nécessaires pour développer ces modèles sont telles que seules quelques entreprises au monde sont capables de les mettre au point. Les résultats ne sont jamais dénués de défauts mais ils sont confondants pour les yeux peu avertis. Des outils annexes permettent en plus de contrôler la génération des images par adjonction de contraintes, par exemple pour forcer la direction et la position de certains éléments de l’image. Les champs d’application sont là encore très spécialisés: cela va des illustrations de presse à la création de nouveaux genres artistiques, ou pourquoi pas l’idéation et la création de nouveaux produits

3 – Tendances et enjeux de l’IA

L’intérêt des algorithmes d’IA réside dans le caractère inédit des résultats et leur flexibilité presque sans limite. Cependant, plusieurs problèmes se posent : la qualité des données, la non-explicitation des sources, la propriété des modèles, la qualité des résultats, la disponibilité (uptime) face aux menaces, la confidentialité [22], la propension à conserver la stabilité des résultats au fil des mises à jour, la dépendance technologique, la rémunération des sources d’entraînement, l’éthique [23], les capacités vantées par le marketing, l’impact environnemental [24], ou encore l’effet d’attrait de la nouveauté. Il est difficile de distinguer la véracité d’un résultat, et l’arrivée de nouveaux modèles détectant le vrai du faux s’assimile à une forme de fuite en avant sans fin. Comme mentionné précédemment, l’entraînement des différents modèles d’IA peut varier de très simple à extrêmement complexe.

L’offre disponible sur le marché est variée, tout comme les outils facilitant la mise en œuvre. Les entreprises du numérique sont en constante évolution logicielle et certaines vont jusqu’à développer leurs propres puces électroniques pour accélérer les traitements tout en réduisant leur impact énergétique

Heureusement, à défaut d’utiliser un modèle extrêmement polyvalent et gigantesque pour tout faire, il est possible d’adapter les principes théoriques de ces algorithmes à des échantillons restreints et spécialisés, adaptés à vos données spécifiques, ou de confier la gestion des systèmes plus complexes à des sociétés spécialisées, dont nombreuses sont des start-ups. Les défis résideront alors dans la capacité à combiner ces algorithmes complexes au sein de votre contexte professionnel, et à évaluer leur apport potentiel à certains de vos processus. Il est donc judicieux d’examiner attentivement les possibilités offertes par ces technologies dans votre contexte spécifique afin de ne pas passer à côté d’opportunités prometteuses.

4 – L’approche de SAP en IA

Heureusement, à défaut d’utiliser un modèle extrêmement polyvalent et gigantesque pour tout faire, il est possible d’adapter les principes théoriques de ces algorithmes à des échantillons restreints et spécialisés, adaptés à vos données spécifiques, ou de confier la gestion des systèmes plus complexes à des sociétés spécialisées, dont nombreuses sont des start-ups. Les défis résideront alors dans la capacité à combiner ces algorithmes complexes au sein de votre contexte professionnel, et à évaluer leur apport potentiel à certains de vos processus. Il est donc judicieux d’examiner attentivement les possibilités offertes par ces technologies dans votre contexte spécifique afin de ne pas passer à côté d’opportunités prometteuses [25].

Parce qu’il s’agit d’un critère RSE important et réclamé, SAP a publié les termes de sa politique d’IA [26] et son manuel d’éthique [27] pour délivrer une IA responsable au cœur des préoccupations des individus. Si l’IA représente actuellement une rupture majeure grâce aux progrès de l’électronique, les futurs progrès de la science pourraient la rendre encore plus vertigineuse. La révolution quantique promet de déployer une puissance de calcul exponentiellement puissante, capable de décoder les codes cryptographique s actuels les plus sûrs. Par ailleurs, les cerveaux artificiels pourraient rivaliser avec les machines actuelles pour nous amener à l’OI, l’intelligence organoïde [28].

En attendant, soyons prudents : toutes nos pensées les plus ambitieuses ne doivent pas conférer des qualités à des systèmes ou des solutions qui n’existent pas encore, ou qui ne verront peut-être le jour que dans un futur lointain.

Téléchargez notre dernier Livre Blanc :

L’intelligence artificielle et SAP

Pour aller plus loin

[2] https://disservin.github.io/stockfish-docs/pages-nnue/docs/nnue.html

[4] https://fr.wikipedia.org/wiki/Algorithme_du_gradient

[5] https://fr.wikipedia.org/wiki/Intelligence_artificielle_g%C3%A9n%C3%A9rale

[6] https://fr.wikipedia.org/wiki/Hallucination_(intelligence_artificielle)

[9] et [10] https://fr.wikipedia.org/wiki/Internet_des_objets

[10] https://github.com/mistralai/mistral-src/blob/main/tutorials/classifier.ipynb

[11] https://fioriappslibrary.hana.ondemand.com/sap/fix/externalViewer/#/detail/Apps(‘F3408’)/S27OP

[12] https://fr.wikipedia.org/wiki/AlphaGo

[13] https://stories.ubisoft.com/article/ia-jeux-video-ennemis-intelligence-the-division-2/

[14] https://www.whichfaceisreal.com

[15] https://fr.wikipedia.org/wiki/Grand_mod%C3%A8le_de_langage

[16] https://github.com/karpathy/llama2.c

[17] https://ai.meta.com/llama/

[18] https://youtu.be/zjkBMFhNj_g

[19] https://www.francetvinfo.fr/article_6130269.html

[20] https://youtu.be/IvY-Abd2FfM

[22] https://next.ink/118351/extraction-donnees-entrainement-ia-generatives-attaque-chatgpt/

[23] https://youtube.com/@Science4Allfrancais/videos

[24] https://arxiv.org/abs/2311.16863

[25] https://learning.sap.com/video/introducing-how-sap-puts-ai-into-the-context-of-business

[26] et [27] https://www.sap.com/documents/2022/01/a8431b91-117e-0010-bca6-c68f7e60039b.html